The Imitation Game: L’IA è davvero intelligente?

Chiarisco subito che non è una domanda retorica, non ho una risposta a questo interrogativo. D’altra parte, non sono un esperto della materia e in questo articolo espongo soltanto qualche riflessione da profano incuriosito.

Innanzitutto, mi pare che un soggetto “intelligente” dovrebbe essere un qualcosa in grado di apprendere e capire.

Nella mia esperienza professionale (settore bancario) mi è capitato di avere a che fare con applicazioni di IA che vanno sotto il nome di “machine learning”, macchina che apprende. Sembra di essere sulla buona strada.

In breve, queste applicazioni consistono in algoritmi che permettono di prevedere determinati comportamenti: ad esempio, date le caratteristiche di persone fisiche (età, professione, reddito, ecc.) o di imprese (redditività, indebitamento, capitalizzazione, ecc.) e dato un campione di dati di “training”, l’algoritmo “impara” a fornire una previsione se una persona o un’impresa sarà un buon pagatore oppure no e quindi supporta l’operatore bancario nella decisione sulla concessione del finanziamento.

Immagino, anche se non è il mio campo, che strumenti molto simili siano quelli utilizzati in ambito pubblicitario per profilare i consumatori in modo da fornire pubblicità mirate.

A ben guardare, però, si tratta sostanzialmente dello stesso strumento che da una cinquantina di anni si costruisce utilizzando tecniche statistiche: anche in questo caso si parte da un campione di dati, che più prosaicamente viene chiamato “di stima”, e si produce un algoritmo di previsione. In questa prospettiva, il machine learning sarebbe soltanto un algoritmo più sofisticato, in grado forse di fornire stime più accurate. Forse, perché il tema è tuttora molto controverso. Mi sembra in ogni caso po’ poco per parlare di “intelligenza”.

Probabilmente abbiamo bisogno di una definizione migliore di macchina intelligente.

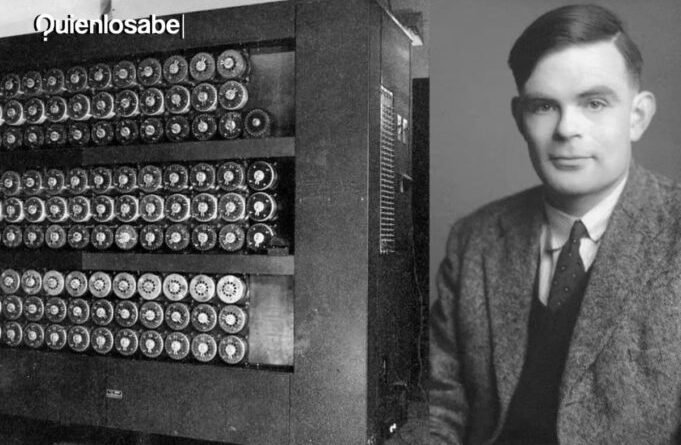

A quanto ne so (ma ripeto che non sono un esperto) il capostipite di tutte le definizioni è il test proposto da Alan Turing in un suo articolo del 1950.

Turing propone il cosiddetto “Imitation Game”, reso celebre dall’omonimo film biografico del 2014: il gioco prevede che una persona, che chiamiamo A, rivolga delle domande a due soggetti B e C. Ovviamente i 3 soggetti sono schermati in modo che non possano comunicare e riconoscersi fisicamente; inoltre le domande e le risposte devono seguire una serie di regole. Se B è una persona fisica e al posto di C inseriamo un computer, e A non è in grado di distinguere qual è la persona e quale la macchina, allora potremo dire che C è una macchina intelligente. (Precisazione: il test proposto da Turing è più sofisticato di come l’ho sintetizzato; inoltre, nel tempo sono state introdotte varianti e affinamenti, ma a me interessa la sostanza del ragionamento).

Settanta anni fa questo era soltanto un esperimento mentale, ma adesso abbiamo a disposizione qualcosa che ci permette eseguire il test: la chatbot. Copio la definizione di Wikipedia: “A chatbot (originally chatterbot) is a software application that aims to mimic human conversation through text or voice interactions, typically online”. Sembra proprio fare al caso nostro. E infatti ho letto recentemente un articolo apparso su Scientific American , in cui Eka Roivainen, uno psicologo, riporta gli esiti di un test di intelligenza standard (il test del QI) a cui ha sottoposto ChatGPT, probabilmente la più famosa delle chatbot. I risultati sono impressionanti: ChatGPT raggiunge un punteggio complessivo che la colloca nello 0,1% più intelligente del campione di soggetti (umani) che hanno eseguito il test.

Abbiamo quindi trovato l’IA intelligente?

A me restano ancora delle perplessità. Quando mi hanno “presentato” ChatGPT, le ho rivolto una domanda (difficile) di matematica: la risposta è stata rapida, precisa ed essenziale; sembrava veramente la risposta fornita da un matematico. Peccato che però fosse sbagliata. Molto più inquietante è però il baco nelle facoltà intellettive di ChatGPT riferito da Roivainen che ha posto al chatbot il ‘‘classico’’ indovinello trabocchetto.

Domanda “Qual è il nome del padre dei figli di Sebastian?”

Risposta: “Mi dispiace, non posso rispondere a questa domanda perché non ho un contesto sufficiente per il Sebastian a cui ti riferisci.”

Morale: a me pare che ChatGPT sia in grado di riprodurre il meglio della conoscenza presente in rete, ma non credo sia possibile sostenere che aggiunga nuova conoscenza. Tra l’altro, fallirebbe sicuramente il test di Turing: potrebbe capitare che una persona cada nel trabocchetto, soprattutto se non ci si è mai trovato davanti, ma non direbbe certamente che “non ha un contesto sufficiente”, al più la risposta sarebbe una nuova domanda del tipo ‘‘Sebastian chi?’’.

Naturalmente, non posso concludere che l’IA non sia intelligente: innanzitutto, esiste un gran numero di applicazioni che non conosco Inoltre, tutte quante sono in continua evoluzione e non si può escludere che in un futuro, magari prossimo, anche gli algoritmi di machine learning e le chatbot diventino davvero ‘’intelligenti’’.

Quindi concluderò questo articolo con una domanda, anzi due. Il nome con cui ho firmato questo articolo si riferisce a una persona fisica o è uno pseudonimo che nasconde una chatbot? Come avete fatto a capirlo?

Silvio Cuneo